In der Welt der datengetriebenen UX-Optimierung reicht Bauchgefühl schon lange nicht mehr aus. Wer wissen will, ob eine Designänderung oder ein neues Feature tatsächlich zu besseren Ergebnissen führt, braucht harte Fakten – und genau hier kommt der Hypothesentest ins Spiel. Ein Hypothesentest ist das Herzstück jedes A/B-Tests. Er hilft dir herauszufinden, ob beobachtete Unterschiede – etwa eine höhere „Add to Cart“-Rate nach einer UI-Anpassung – wirklich auf deine Optimierung zurückzuführen sind oder einfach nur Zufall. In diesem Artikel schauen wir uns Schritt für Schritt an, was Begriffe wie Nullhypothese, Alpha-Fehler oder statistische Signifikanz bedeuten, wie Hypothesentests funktionieren – und wie du das Ganze praktisch nutzt, um fundierte Entscheidungen in deinen Website-Experimenten zu treffen.

1. Einführung in den Hypothesentest

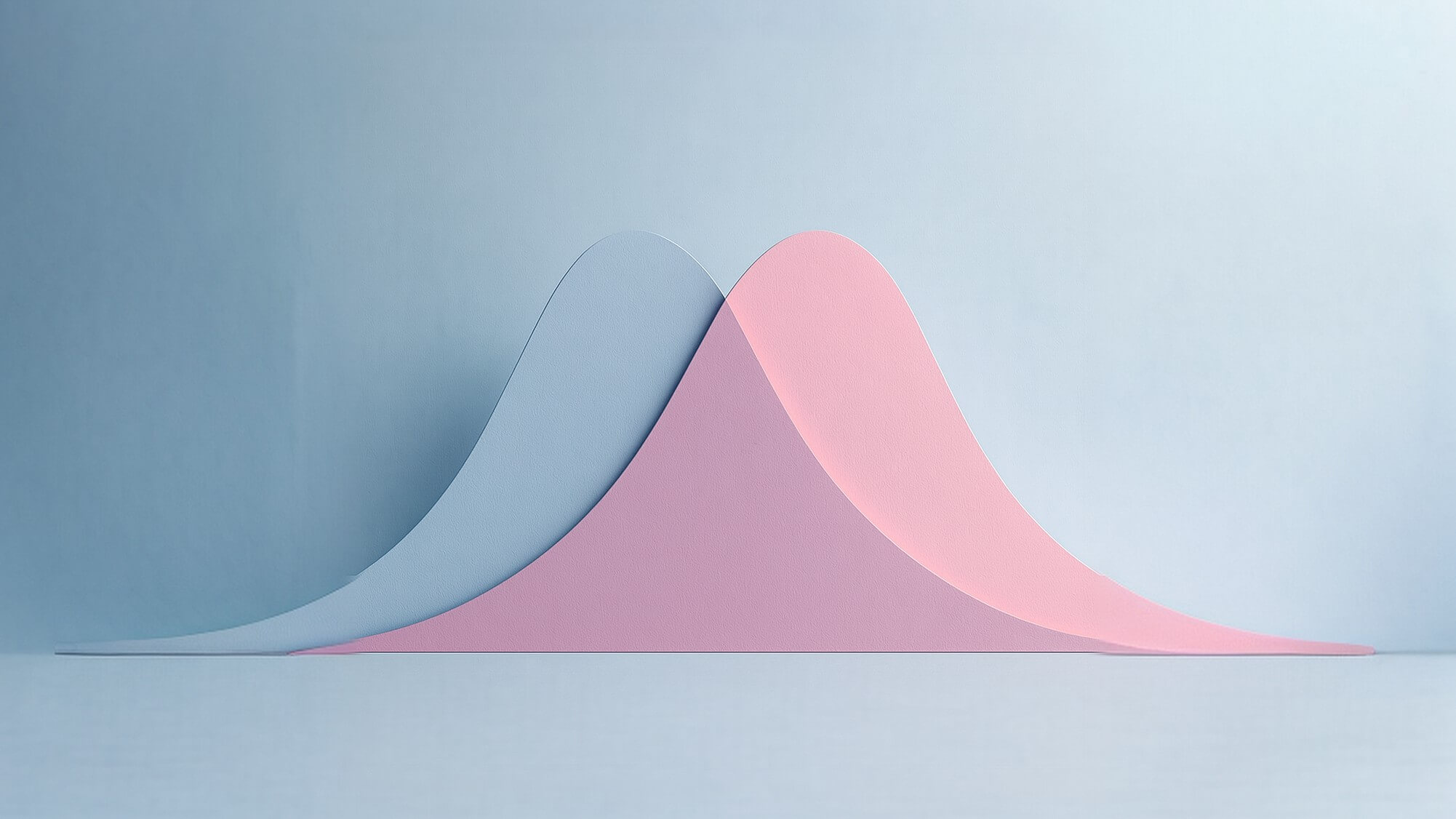

Ein Hypothesentest ist ein statistisches Verfahren, um zu prüfen, ob ein beobachteter Unterschied zwischen zwei Gruppen (siehe Abb. 1) zufällig ist oder auf einen echten Effekt zurückzuführen ist. Statt dich auf dein Bauchgefühl zu verlassen, nutzt du den Hypothesentest, um das objektiv und mathematisch fundiert zu entscheiden.

Abb. 1: Darstellung zweier Testgruppen A und B – bspw. eine Änderung auf der Produktseite

Was bedeutet das in der Praxis

Du möchtest wissen, ob eine neue UX-Version deiner Produktseite wirklich mehr „Add to Cart“-Klicks erzeugt als die alte.

Wann wird der Hypothesentest benötigt?

Ein Hypothesentest kommt zum Einsatz, wenn man anhand einer Stichprobe eine Aussage über die Grundgesamtheit, also das Verhalten aller Besucher in deinem Online-Shop, aussagen möchte.

Abb. 2: Die Grundgesamtheit sind alle Nutzer, die jemals in deinem Shop waren und sein werden. Daher betrachtet man immer nur eine Stichprobe an Daten.

Wieso nutzen wir Hypothesentests?

Wir arbeiten mit Hypothesentests, weil wir in der Praxis nie die komplette Grundgesamtheit kennen – also nicht alle Nutzer, die unseren Online-Shop jemals besucht haben oder in Zukunft besuchen werden. Was wir immer sehen, ist nur ein Ausschnitt: die Nutzer, die im Testzeitraum tatsächlich auf der Seite waren, die einer Testgruppe zugeteilt wurden und die überhaupt Tracking- oder Consent-Daten liefern. Deshalb basiert jeder A/B-Test auf einer Stichprobe.

2. Was ist eine Hypothese?

Eine Hypothese ist eine konkrete, überprüfbare Annahme über einen Sachverhalt. Sie ist so formuliert, dass man anhand von Daten – etwa aus einem Experiment oder einer Umfrage – prüfen kann, ob sie zutrifft oder widerlegt werden muss.

In der Praxis

Im Folgenden wird eine Beispiel aufgegührt, wie es in der Praxis bereits schon getestet worden ist.

Ausgangssituation

Wir möchten herausfinden, ob bei hochpreisigen Produkten mit einer Rabattierung von über 1.000 € die Art der Rabattdarstellung einen Einfluss auf das Nutzerverhalten hat. Konkret untersuchen wir, ob eine dargestellte Ersparnis in absoluter Rabattangabe in Euro im Vergleich zu einer prozentualen Darstellung zu einer höheren Add-to-Cart-Rate führt.

Abb. 3: Auswirkung der unterschiedlichen Darstellung der Ersparnis beim Kauf des Produktes auf die Add-to-Cart Rate

Annahme

Wenn wir hohe Rabatte bei Produkten über 1.000 € in absoluten Euro-Beträgen statt in Prozent darstellen, dann performen diese Produkte besser – weil große absolute Zahlen für Nutzer deutlich eindrucksvoller, leichter verständlich und emotional wirkungsvoller sind als abstrakte Prozentangaben.

3. Nullhypothese und Alternativhypothese

Um einen Hypothesentest durchführen zu können, benötigst du immer zwei klar definierte Annahmen: die Nullhypothese H₀ und die Alternativhypothese H₁.

Nullhypothese H₀

Die Nullhypothese H₀ geht davon aus, dass es kein Unterschied zwischen zwei Testgruppen geben wird.

Beispiel einer Nullhypothese H₀

Die Darstellung der Ersparnis in – absolute Euro-Angabe versus prozentuale Angabe – hat keinen Einfluss auf die Add-to-Cart-Rate bei hochpreisigen Produkten mit mehr als 1.000 € Rabatt. (angelehnt an das Beispiel aus Abb. 3)

Alternativhypothese H₁

Die Alternativhypothese H₁ geht davon aus, dass es einen Unterschied zwischen zwei Testgruppen geben wird.

Beispiel einer Alternativhypothese H₁

Die absolute Rabattdarstellung als Ersparnis in Euro führt bei hochpreisigen Produkten mit mehr als 1.000 € Rabatt zu einer höheren Add-to-Cart-Rate als die prozentuale Darstellung. (angelehnt an das Beispiel aus Abb. 3)

Ziel des Tests ist es, genügend Beweise zu finden, um die Nullhypothese zu verwerfen und damit H₁ zu unterstützen.

4. Der Alpha-Fehler (Fehler 1. Art)

Der Alpha-Fehler – auch Fehler 1. Art oder schlicht False Positive genannt – beschreibt die Situation, in der ein Test einen vermeintlichen Effekt meldet, obwohl tatsächlich keiner vorhanden ist. Der Begriff „False Positive“ erklärt sich dabei fast von selbst: Die Daten erzeugen zufällig den Eindruck eines positiven Ergebnisses (positive), und wir würden fälschlicherweise (false) die Nullhypothese verwerfen. In der Praxis legen Unternehmen fest, wie viel Risiko eines solchen Irrtums sie akzeptieren möchten. Im A/B-Testing bewegt sich dieser Wert – das sogenannte Signifikanzniveau – in der Regel zwischen 5 % und 10 %.

Was bedeutet ein Signifikanzniveau von 5%?

Ein Alpha-Level von 5 % bedeutet konkret: Wir akzeptieren, dass etwa jeder zwanzigste Test rein zufällig so aussieht, als wäre die neue Variante besser, obwohl sie in Wahrheit keinerlei Vorteil bietet. Damit ist der Alpha-Fehler kein Randphänomen, sondern ein bewusst einkalkulierter Bestandteil datengetriebener Entscheidungsfindung.

5. Der p-Wert

Bei der Berechnung des p-Werts gehen wir grundsätzlich davon aus, dass die Nullhypothese H₀ wahr ist. Das bedeutet: Wir nehmen an, dass es in der Grundgesamtheit – also bei allen Nutzern unseres Online-Shops – keinen echten Unterschied zwischen den Varianten A und B gibt. Der p-Wert beschreibt anschließend, wie wahrscheinlich es wäre, Daten zu beobachten, die mindestens so große Unterschiede zwischen den Testgruppen A und B zeigen wie in unserer Stichprobe. Liegt dieser p-Wert unter dem gewählten Signifikanzniveau (beispielsweise 5 %), gelten die beobachteten Daten als so unwahrscheinlich, dass wir die Nullhypothese verwerfen und davon ausgehen, dass zwischen den Varianten tatsächlich ein Effekt existiert.

p-Wert leichter erklärt

Der p-Wert ist im Kern ein Unwahrscheinlichkeitsmesser. Er zeigt uns, wie überraschend groß der Unterschied zwischen A und B wäre, wenn es in Wahrheit gar keinen echten Unterschied gibt. Ein hoher p-Wert bedeutet, dass der beobachtete Unterschied gut durch Zufall erklärbar ist – wir behalten die Nullhypothese also bei. Ein niedriger p-Wert dagegen sagt uns: „Diese Daten wären fast nie zufällig entstanden.“ Wird beispielsweise bei einem Signifikanzniveau von 5 % ein p-Wert von 3 % gemessen, heißt das: Nur in 3 von 100 Fällen würden wir einen so großen Unterschied rein zufällig beobachten. Genau deshalb interpretieren wir ein solches Ergebnis als Hinweis auf einen echten Effekt.

6. Der Ablauf eines Hypothesentests

Der typische Ablauf sieht wie im folgendem aus (klicke auf die jeweiligen Schritte, um mehr zu erfahren oder scrolle nach unten):

- Hypothesen formulieren (H₀ und H₁)

- Signifikanzniveau (α) festlegen – z. B. 0,05 (5 %)

- Daten sammeln – Stichprobe ziehen, z. B. Nutzer-Verhalten messen

- Teststatistik berechnen – z. B. bei Mittelwertvergleichen ein t-Wert

- p-Wert bestimmen – Wahrscheinlichkeit, dass der beobachtete Effekt (oder ein extremerer) unter der Annahme, dass H₀ gilt, auftreten würde

- Vergleich p-Wert mit α

- Wenn p < α: H₀ ablehnen → H₁ gilt als wahrscheinlich

- Wenn p ≥ α: H₀ nicht ablehnen → keine ausreichende Evidenz für H₁

- Ergebnis interpretieren – Effektgröße, Relevanz, praktische Bedeutung prüfen

Dieser Ablauf stellt sicher, dass du deine Schlussfolgerung auf valide statistische Grundlagen stellst.

7. Praxisbeispiel

In diesem Beispiel betrachten wir eine Produktdetailseite eines beliebigen Artikels. Ziel ist es herauszufinden, ob die Platzierung des Produktpreises das Nutzerverhalten beeinflusst. Abbildung 4 zeigt zwei nahezu identische Varianten der Seite: Der einzige Unterschied besteht darin, dass der Preis – in Orange hervorgehoben – in Variante A direkt über dem „Add-to-Cart“-Button und in Variante B unmittelbar unter dem Produktnamen positioniert ist.

1. Hypothesen formulieren

Die Annahme

Wenn der Preis weiter oben auf der produktseite steht, dann steigt die Add2Cart-Rate, weil die wichtigste Information des Produktes schneller wahrgenommen wird.

Die Nullhypothese H₀

Es gibt keinen echten Unterschied zwischen Variante A und B. Platzierung des Preises hat keinen Einfluss auf Add2Cart-Rate.

Die Alternativhypothese H₁

Variante B performed besser, weil der Preis früher ins Blickfeld fällt (siehe Annahme) → Add2Cart-Rate höher als in Variante A.

Abb. 4: AB-Test zur Auswirkung der unterschiedlichen Platzierung des Produktpreises

2. Signifikanzniveau α festlegen

Wie üblich wählen wir α = 0,05 (5 %). Das bedeutet: Wir akzeptieren eine 5-%-Wahrscheinlichkeit, dass wir einen Effekt sehen, der eigentlich nur Zufall ist (False Positive / Alpha-Fehler).

3. Daten sammeln

Während des A/B-Tests werden über einen festgelegten Zeitraum echte Nutzerdaten erhoben:

- Anzahl der Besucher je Variante

- Add-to-Cart-Events

- Add-to-Cart-Rate

- Umsatz pro Variante (Revenue)

Wir nehmen an, der Test lief zwei Wochen und beide Varianten erhielten gleich viel Traffic. Wir erhalten folgendes Ergebnis:

| Kennzahl | Variante A | Variante B |

|---|---|---|

| Add2Cart | Basis | +11% |

| Revenue | Basis | +12% |

Tab. 1: Exemplarische Testergebnisse eine AB-Tests

Jetzt müssen wir aber noch unbedingt darauf achten, ob der Test statistisch signifikant ist!

4. Teststatistik berechnen

Da wir zwei Mittelwerte bzw. Raten vergleichen (Add-to-Cart-Rate A vs. B), verwendet man typischerweise einen sog. t-Test oder z-Test für zwei unabhängige Stichproben. Das Ergebnis der Teststatistik ist später Basis für den p-Wert. Dafür gibt es allerdings Tools und Websiten, so dass du das nicht selbst berechnen musst.

5. p-Wert bestimmen

Nehmen wir exemplarisch an, der Test liefert:

p = 0,018

Das bedeutet: → Wenn die Nullhypothese wahr wäre, würden wir nur in 1,8 % aller Fälle zufällig so einen starken Unterschied beobachten.

6. Vergleich von p-Wert und α

Das Signifikanzniveau und der p-Wert ergeben sich wie folgt:

- p = 0,018

- α = 0,05

- p < α

Daher lehnen wir die Nullhypothese ab:

- H₀ verwerfen → H₁ gilt als wahrscheinlich

- Variante B erzeugt signifikant mehr Add-to-Cart-Klicks und Revenue

Das Ergebnis ist statistisch signifikant!

7. Ergebnis interpretieren

Inhaltlich bedeutet das:

- Die Preisplatzierung in Variante B führt nachweislich zu mehr Interaktionen

- Die Add-to-Cart-Rate steigt um 11 %

- Der Revenue sogar um 12 %

- Der Vorteil ist statistisch signifikant, also sehr wahrscheinlich real

- Die ursprüngliche Hypothese – Variante B performt besser, weil der Preis leichter zu finden ist – wird durch die Daten gestützt.

Praktisch gesprochen:

- Variante B ist die Gewinner-Variante und sollte ausgerollt werden.

- Zusätzlich empfiehlt sich, qualitative Analysen (Heatmaps, Scroll-Maps, Eye-Tracking) zu prüfen, um zu verstehen, warum die bessere Performance zustande kam.

FAQs zum Hypothesentest

Was genau ist eine Hypothese?

Eine Hypothese ist eine gezielte, überprüfbare Annahme über einen bestimmten Sachverhalt. Sie beschreibt, was man erwartet zu beobachten, bevor man Daten erhebt – etwa in einem Experiment, einer Umfrage oder einem A/B-Test.

Warum formuliert man Hypothesen überhaupt?

Hypothesen helfen, Forschung und Experimente zu strukturieren. Statt einfach „ins Blaue hinein“ zu testen, legst du mit einer Hypothese klar fest, welche Veränderung du erwartest und wie du sie messen willst.

Was ist der Unterschied zwischen Null- und Alternativhypothese?

- Nullhypothese (H₀): Es gibt keinen Unterschied oder Effekt

- Alternativhypothese (H₁): Es gibt einen Unterschied oder Effekt.

Was ist das Ziel eines Hypothesentests?

Solange, bis die geplante Stichprobengröße erreicht ist und du möglichst mindestens eine volle Zyklusdauer des Nutzerverhaltens (z. B. eine Woche oder mehr) beobachtet hast – oft mehrere Wochen.

Was ist der Alpha-Fehler?

Der Alpha-Fehler beschreibt den Fall, dass ein statistischer Test einen Effekt feststellt, obwohl in Wahrheit keiner existiert. Kurz: Du glaubst, etwas hat sich verbessert, aber die beobachtete Veränderung ist eigentlich nur Zufall.

Was ist das Signifikanzniveau (α)?

Das Signifikanzniveau ist die maximal akzeptierte Wahrscheinlichkeit, einen Alpha-Fehler zu machen. Es wird vor dem Experiment festgelegt. Üblich sind 5 % (α = 0,05) oder 1 % (α = 0,01).

Was bedeutet „p-Wert kleiner als 0,5“?

Wenn der p-Wert kleiner als 0,05 ist (bei α = 0,05), gilt das Ergebnis als statistisch signifikant – d. h. die Wahrscheinlichkeit, dass dieser oder ein extremerer Unterschied unter der Annahme von H₀ entsteht, liegt unter 5 %.

Wie lange sollte ein A/B-Test laufen?

Das Ziel ist, anhand von Stichprobendaten eine Entscheidung zu treffen, ob die Nullhypothese verworfen werden kann – also ob ein beobachteter Unterschied wahrscheinlich echt ist.

Fazit: Hypothesentests als Grundpfeiler

Ein Hypothesentest ist das Herzstück deiner datengetriebenen UX-Optimierung. Er bietet dir eine strukturierte, statistisch fundierte Methode, um zu entscheiden, ob eine Gestaltung, ein Feature oder eine Veränderung wirklich Wirkung zeigt – oder ob das beobachtete Ergebnis nur Zufall war. Achte stets darauf, dass deine Stichprobe ausreichend groß ist und du sowohl statistische Signifikanz als auch praktische Relevanz im Blick hast. So gehst du von bloßer Intuition zu fundiertem Handeln über.

Autor

Marc ist der Gründer von Seamless Convert. Er teilt in diesen Beiträgen sein Wissen jahrelanger Expertise im Bereich der datengetriebenen UX-Optimierung.

Na, neugierig geworden?

Entdecke weitere spannende Themen und praxisnahe Insights in den anderen Beiträgen.